Jenkins Pipeline script를 작성하고 자동 배포 테스트를 진행하던 중, Docker 사용과 관련해 문제가 있었다.

stage('[Backend] Image Build & DockerHub Push') {

when {

expression { env.GITHUB_PR_STATE != 'opened' }

}

steps {

script {

docker.withRegistry('', registryCredential) {

sh "docker build -t $imageName:latest ."

sh "docker push $imageName:latest"

}

}

}

}

Docker를 활용해 Docker image를 구성하고, DockerHub로 push하는 과정에서 에러 로그가 출력되었다. docker: not found 라는 로그를 확인했고 이는 Pipeline을 실행하는 Jenkins 컨테이너 내부에서 docker 명령어를 사용하지 못해 발생한 에러였다.

이 문제를 해결하기 위해, 방법을 찾아나가는 과정에서 수많은 지식을 얻게 되어 그 과정을 기록해보고자 한다.

Jenkins 컨테이너 안에서 docker 명령어를 찾을 수 없는 문제

Jenkins를 통해 CI/CD를 구축했기 때문에, GitHub push hook이 감지되면 호스트에서 실행 중인 Jenkins 컨테이너가 빌드 테스트를 진행하고, Docker image를 만들어 DockerHub로 push 하는 과정이 이루어져야 했다. 이 과정에서 docker build, docker push 명령어를 사용해야 했다. 하지만 Jenkins 컨테이너 내부에 접속해 docker 명령어를 입력하면 docker: not found 에러가 떴다.

Docker in Docker vs Docker out of Docker

구글링을 통해 관련 에러에 대한 몇가지 글을 읽어보니, 이러한 상황은 흔했다. 도커로 실행한 컨테이너 내부에서 다시 도커를 사용해야 하는 상황이었고, 해결 방법으로는 크게 두가지 방법이 있었다.

1. Docker in Docker (DinD)

컨테이너 내부에서 또 다른 Docker 데몬을 실행하여 그 내부에서 컨테이너를 실행하는 방식이다. --privileged 옵션을 사용하여 컨테이너 내부에서 내부에 설치된 Docker 데몬을 실행한다. 독립적인 Docker 환경을 제공하고, 컨테이너 내부에서 실행된 컨테이너는 호스트의 Docker 엔진과 분리될 수 있지만, 보안 문제와 성능 오버헤드가 발생할 수 있다.

2. Docker out of Docker (DooD)

컨테이너 내부에서 Docker CLI를 실행하되, 실제로는 호스트의 Docker 데몬을 사용하여 컨테이너를 실행하는 방식이다. 컨테이너 내부에서 Docker CLI를 실행하지만, 내부에 별도의 Docker 데몬을 설치하지는 않는다. -v /var/run/docker.sock:/var/run/docker.sock 옵션을 사용하여 호스트의 Docker 소켓을 공유한다. 호스트의 기능을 빌려 사용하는 것이므로 컨테이너 내부에서 Docker CLI는 사용할 수 있지만 새로운 컨테이너 서비스를 만들지는 않는다. 성능상 유리하지만, 컨테이너 내부에서 실행된 Docker 명령어가 호스트의 Docker 데몬과 직접 통신하기에 컨테이너가 호스트의 Docker를 직접 제어할 수 있어 역시 보안 문제가 있다.

DinD에서 --privileged 옵션을 적용하면 컨테이너가 root 권한을 갖게 되어, 호스트의 중요한 시스템 파일을 수정할 수 있다. 즉, 컨테이너가 사실상 호스트 시스템을 제어할 수 있는 수준의 권한을 갖게 된다. 이러한 이유로 공식 Docker에서는 DinD보다는 DooD를 권장하고 있다. 컨테이너가 호스트의 Docker를 제어하는 DooD 역시 보안 문제가 있긴 하나, 호스트 시스템을 직접 제어하는 수준의 권한을 컨테이너가 갖게 되는 DinD 방식에 비해서는 비교적 안전하다고 한다.

DinD 방식에서 --privileged 옵션이 필요한 이유

DinD 방식에서 이 옵션이 필요한 이유가 궁금해졌다. 그래서 더 자세히 알아봤다.

Docker 컨테이너의 원리

Docker 컨테이너 기술은 리눅스 컨테이너(LXC)를 활용한 기술로, 컴퓨터에 독립적인 컴퓨팅 공간을 생성해낸다. 기존의 가상머신(VM)과 가상 환경 구조에서 차이를 보인다. VM은 OS를 가상화 하는 반면, 컨테이너는 호스트 OS의 kernel을 공유하며 단순히 하나의 격리되어 있는 프로세스로써 동작한다. 격리 측면에서만 보면 VM이 컨테이너보다 유리하지만 VM이 동작하는 데 컨테이너에 비해 많은 시간이 소요된다. 컨테이너들은 하나의 kernel을 공유하므로 자원이나 성능 면에서 VM에 비해 효율적이다.

VM은 kernel을 포함해 OS 전체의 복사본을 실행하는 반면, Docker 컨테이너 기술을 적용하면 다수의 프로세스가 호스트 OS의 kernel을 공유하면서도, 각 프로세스를 격리된 환경에서 실행할 수 있다.

이에 활용되는 핵심 기술이 리눅스의 namespace와 cgroups이다.

namespace

하나의 시스템에서 수행되지만 각각 별개의 독립된 공간처럼 격리된 환경을 제공하는 경량 가상화 기술이다. 한 프로세스가 한 namespace에 포함되면 프로세스는 그 namespace가 허용하는 것들만 접근할 수 있게 된다.

cgroups (control groups)

cgroups(control groups)는 프로세스 그룹의 시스템 자원 사용량을 관리한다. cgroups는 프로세스와 스레드를 그룹화하고 그 그룹 안에 존재하는 프로세스의 스레드 관리를 수행하기 위한 기능으로, 자원 사용량이 많은 프로세스나 스레드를 제어한다.

리눅스의 namespace, cgroups 기술을 활용한 Docker 컨테이너는 철저하게 호스트 환경과 격리된 환경에서 컨테이너 내부 프로세스가 동작하게 한다. DinD 방식에서 --privileged 옵션은 이러한 격리를 풀어 컨테이너가 호스트의 리소스에 접근할 수 있게 한다. DinD의 핵심은 컨테이너 내부에서 호스트 Docker 데몬과 다른 새로운 Docker 데몬을 실행시키는 것인데, --privileged 옵션이 컨테이너 내부에서 새로운 Docker 데몬을 실행할 수 있도록 격리 환경을 풀어준다.

Docker 컨테이너 기술에 대해 자세하게 알아보고 나니, DinD 사용은 지양해야겠다는 생각이 들었다. DinD의 장점은 호스트 Docker와 완벽하게 격리된 환경에서 컨테이너 내부 Docker를 사용해 호스트 의존도를 낮춘다는 점인데, 아이러니하게도 이를 위해서 호스트 전체 시스템 자원에 대한 제어 권한을 컨테이너에게 부여해야하는 딜레마가 발생한다. 호스트 Docker 기능만을 공유하는 DooD 방식에 비해 보안적으로 훨씬 위험한 방식이라는 게 명확해졌다.

DooD 방식 선택

위의 이유로 DooD 방식으로 Jenkins 컨테이너 내부에서 호스트 Docker를 사용하기도 했다. 이를 위해선 docker.sock 파일을 호스트와 Jenkins 컨테이너가 공유하고 있어야 했다.

docker run -d --env JENKINS_OPTS=--httpPort=포트번호 -v /etc/localtime:/etc/localtime:ro -e TZ=Asia/Seoul -p 포트번호:포트번호 -v /jenkins:/var/jenkins_home -v /var/run/docker.sock:/var/run/docker.sock -v /usr/local/bin/docker-compose:/usr/local/bin/docker-compose --name jenkins -u root jenkins/jenkins:jdk17

나는 위 명령어를 통해 Jenkins 컨테이너를 실행했었고, -v /var/run/docker.sock:/var/run/docker.sock 으로 볼륨을 마운트했기 때문에, Jenkins Pipeline 설정 바꾸지 않고도 해당 방식을 선택할 수 있었다.

docker.sock 파일 볼륨 마운트가 안되어 있다면 DinD 방식을 선택하거나 Jenkins 컨테이너를 삭제한 후 새로 실행시켜 Credentials, Plugin 등의 설정을 다시 진행해야 한다.

호스트와 컨테이너의 docker group이 격리되어 관리된다.

구글링을 하던 중 많은 자료에서 DooD 방식에서는 docker 그룹에 jenkins 사용자를 추가해야 한다고 했다. 나 또한 Jenkins 컨테이너에 접속해서 usermod -aG docker jenkins 명령어를 입력하고자 했다. 하지만, Jenkins 컨테이너 내부에서는 docker 그룹이 검색되지 않았다. 지금 와서 생각하면 컨테이너는 호스트로부터 완벽하게 독립적으로 실행되고 있었다는 것이다.

docker 그룹이 존재하는 지를 확인했다. 먼저 호스트 서버에서 이 명령어를 실행하니 docker:x:999:ubuntu 라는 출력이 떴다. ubuntu 사용자가 호스트 docker 그룹에 속해 있다는 뜻이었고, jenkins 사용자도 이 docker 그룹에 추가하면 될 것이라고 생각했다.

// docker group 확인

cat /etc/group | grep docker

그래서 호스트 서버에서 jenkins 사용자가 속한 그룹을 찾아보려 했지만, 실패했다. Jenkins를 호스트와 독립된 컨테이너로 실행해서 그룹 또한 호스트와 격리되어 관리되고 있었다.

// jenkins 사용자의 group 확인

groups jenkins

다음으론 Jenkins 컨테이너 내부에 접속했다. 호스트 서버와 마찬가지로 docker 그룹을 조회해봤지만 docker 그룹 자체가 존재하지 않았다.

// Jenkins 컨테이너 bash 접속

docker exec -it jenkins /bin/bash// docker group 확인

cat /etc/group | grep docker

Jenkins 컨테이너 내부 bash에서 다음의 명령어를 입력하자 역시나 jenkins 사용자는 Jenkins 컨테이너 내부에만 존재하는 것을 확인할 수 있었다.

// jenkins 사용자의 group 확인

groups jenkins

docker group이 문제의 원인은 아니었다.

그러던 중 중요한 정보를 얻게 되었다. Docker 컨테이너는 별다른 설정이 없으면 root 계정으로 실행된다는 것이었다. 이 글을 읽고 바로 작성해 둔 Dockerfile을 확인하니 USER로 jenkins 사용자를 설정하는 부분이 없었다. 내가 설정한 것에 따르면 Jenkins 컨테이너가 root 계정 권한으로 Docker 명령어를 실행하려는 것인데, Docker 명령어를 실행할 수 없다는 게 납득이 안됐다. 이는 곧 docker group 설정이 잘못되어 발생한 문제가 아니었다는 뜻이었다.

마음을 가다듬고 다시 생각해보았다. 우선 사용자 권한 문제는 아니라는 결론이었다. Docker를 컨테이너 내부에서 사용할 수 있는 상황이었다면 Permission denied 오류가 출력됐지, docker: not found 오류가 출력되진 않았을 것이다. not found 라는 말을 그대로 풀이하면 Docker를 찾을 수 없어 출력된 오류였다.

Docker 소켓 파일과 Docker 데몬

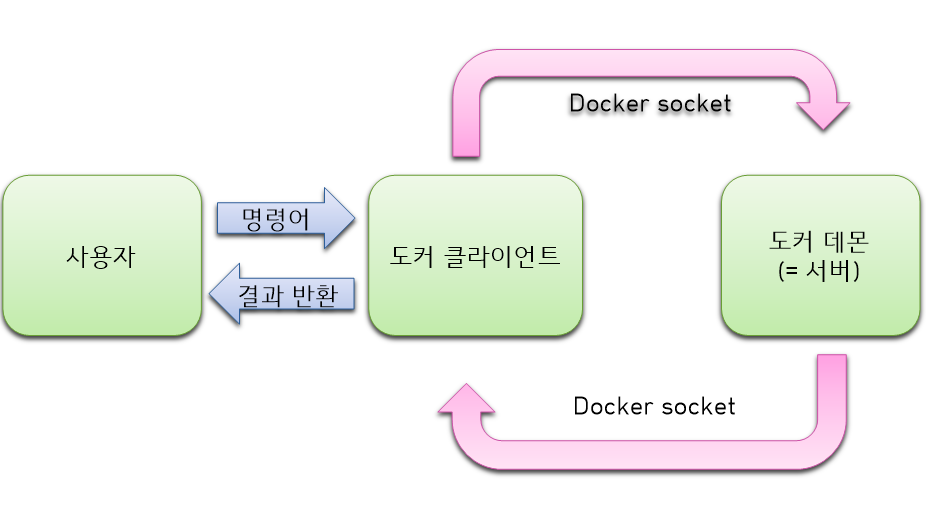

처음으로 돌아와 Jenkins 컨테이너를 실행할 때 사용한 명령어를 봤다. 호스트의 docker.sock 파일을 분명 볼륨 마운트 해줬으나 컨테이너가 Docker를 사용하지 못하는 상황이 이해가 되지 않았다. 그래서 docker.sock 파일에 대해 찾아보던 중 어떤 분이 docker 관련해서 도식화해놓은 그림을 보고 결정적인 해답을 찾게 되었다.

소켓 파일

개념: 컴퓨터 내에서 프로세스 간 통신을 위한 인터페이스를 제공하는 파일 형태의 통신 채널

역할: 로컬에서 프로세스 간 네트워크 통신 없이도 데이터를 주고 받을 수 있게 함

Docker 소켓 파일

개념: docker.sock 파일로, Docker 데몬과 클라이언트 간의 통신을 가능하게 해줌

역할: 사용자가 입력한 명령어를 클라이언트에서 Docker 데몬으로 전달

Docker 소켓 파일에서 등장하는 클라이언트 개념은 명령어 도구 또는 API를 뜻하는데, 이는 사용자가 입력이라고 봐도 된다. 이 설명에 따르면 Docker 소켓 파일만으로는 Docker 명령어를 Docker 데몬에 전달할 수 없는 것이었다. 결과적으로 Docker의 서버 역할을 하는 Docker 데몬 쪽으로 명령이 전달되어야 했고, 그렇다면 컨테이너도 데몬을 인식해야 했다. 그렇다면 Jenkins 컨테이너 내부에도 Docker 관련 패키지가 설치되어야 했다.

Jenkins 컨테이너에 Docker를 설치하는 과정에서 생긴 문제

호스트 서버에 Docker 패키지를 설치할 때 입력했던 명령어를 Jenkins 컨테이너 내부 bash에서 그대로 입력했다. 그러나 Docker 관련 패키지들과 GPC key를 설치하는 과정에서 다른 문제를 보게 되었다.

Hit:1 http://deb.debian.org/debian bookworm InRelease

Hit:2 http://deb.debian.org/debian bookworm-updates InRelease

Hit:3 http://deb.debian.org/debian-security bookworm-security InRelease

Ign:4 https://download.docker.com/linux/ubuntu bookworm InRelease

Err:5 https://download.docker.com/linux/ubuntu bookworm Release

404 Not Found

Docker의 패키지 리포지토리가 Ubuntu에서 사용될 수 없고, Debian에서 Ubuntu 리포지토리를 참조하려고 했기 때문에 발생한 문제였다. 이 문제를 해결하려면 잘못된 리포지토리를 모두 찾아 제거해야 했다.

apt로 설치한 리포지토리 항목이 저장되어 있는 파일이 sources.list 였고, 해당 파일 안에서 Docker 관련 리포지토리 항목을 삭제해야 했다. 내 에러 메시지를 보면 Docker와 관련된 ubuntu 리포지토리들이 문제를 일으키고 있었고, 이걸 삭제해줘야 했다.

sudo cat /etc/apt/sources.list

위에서 사용해봤던 grep 명령어로, /etc/apt 목록에서 docker가 포함된 모든 리포지토리를 검색해보았다.

cd /etc/apt | grep -r "docker"

/etc/apt/sources.list /etc/apt/sources.list.d/ /etc/apt/sources.list.d/archive_uri-https_download_docker_com_linux_ubuntu-bookworm.list:deb [arch=amd64] https://download.docker.com/linux/ubuntu bookworm stable /etc/apt/sources.list.d/archive_uri-https_download_docker_com_linux_ubuntu-bookworm.list:# deb-src [arch=amd64] https://download.docker.com/linux/ubuntu bookworm stable

Docker 리포지토리가 /etc/apt/sources.list.d/ 디렉터리에 있는 archive_uri-https_download_docker_com_linux_ubuntu-bookworm.list 파일에 설정되어 있다는 출력을 볼 수 있었다.

그래서 다음의 명령어를 입력해 해당 파일를 완전히 제거해주었다.

sudo rm /etc/apt/sources.list.d/archive_uri-https_download_docker_com_linux_ubuntu-bookworm.list

이후 해당 변경을 반영하기 위해 패키지 목록을 업데이트 했다.

apt-get update

Hit:1 http://deb.debian.org/debian bookworm InRelease

Hit:2 http://deb.debian.org/debian bookworm-updates InRelease

Hit:3 http://deb.debian.org/debian-security bookworm-security InRelease

Reading package lists... Done

그러니 오류를 일으키던 docker 리포지토리들이 더이상 발견되지 않았다. 충돌이 일어났던 것은 Docker가 설치될 때 base image로 debian 이나 ubuntu 둘 중 하나를 사용하게 되는데, 나의 경우엔 컨테이너 내부에 이미 debian 기반의 base image가 설치되어 있었기 때문에 오류가 출력된 것이었다. 구글링을 하면서 다양한 자료들을 참고하고 따라하다 보니 나도 모르게 base image를 여러 번 설치하게 되었던 것 같다.

그냥 넘어갈 수는 없어 검색을 해보니, 본인의 상황에 적합한 Docker base image를 사용하면 될 것 같다는 결론이 났다.

최종 해결 방법

1. Jenkins 컨테이너 접속

docker exec -it jenkins /bin/bash

2. Docker 설치 전 필요한 패키지 설치

sudo apt-get install \

apt-transport-https \

ca-certificates \

curl \

gnupg-agent \

software-properties-common

3. Docker 패키지 설치

sudo apt-get -y install docker-ce docker-ce-cli containerd.io docker-buildx-plugin docker-compose-plugin

결과적으로 이렇게 하니 DooD 방식으로, 호스트에서 동작 중인 Docker를 Jenkins 컨테이너 내부에서 사용할 수 있게 되었다. 뭔가 간단한 것 같으면서도 내가 의문을 품는 모든 것들에 대해 정리된 글을 찾는 게 어려웠기 때문에, 정말 많은 글을 읽어본 것 같다. 사실 DooD가 Docker out of Docker의 줄임말이라는 것도 내가 혼란스러웠던 이유 중 하나인게, out of 라는 것을 보고 컨테이너 내부에 Docker를 설치해야 하는 상황을 떠올리기 쉽지 않았던 것 같다.

악명 높은 Jenkins 답게, Jenkins 관련한 에러를 참 많이 마주했는데 리눅스 명령어와 Docker에 대해 깊게 알아볼 수 있어서 좋은 기회라고 생각한다. 누군가에게 이 글이 문제를 해결하는 시간을 단축하는 글이 되길 바라며 !

'Infrastructure' 카테고리의 다른 글

| Windows11에서 Ubuntu 및 Docker 환경 구성하기 (0) | 2025.02.28 |

|---|---|

| Jenkins로 GitHub CI/CD Pipeline 구축하기 (0) | 2025.02.26 |

| Jenkins로 GitHub CI 구축하기 (0) | 2025.02.21 |

| Git flow에서 CI/CD는 어떤 브랜치에 구축하는 것이 좋을까? (0) | 2025.02.20 |

| 배포 과정에서 만난 문제들과 해결 과정 (1) | 2025.02.11 |